🗣 SL提问: ai大模型的发展

✍️ Ai批改: AI大模型的发展是人工智能领域近年来最显著的进步之一。这些模型,也被称为大型语言模型(LLMs),在自然语言处理(NLP)和其他应用中展现出了前所未有的能力。以下是关于AI大模型发展的一个概述:

早期发展

AI大模型的雏形可以追溯到早期的语言模型,但它们的实际发展和应用是在深度学习技术取得重大突破后开始的。特别是Transformer架构的引入,彻底改变了NLP领域,为大型语言模型的开发奠定了基础。

关键里程碑

1、Transformer架构(2017年):由Vaswani等人在论文《注意力就是你需要的全部》(Attention Is All You Need)中提出的Transformer架构,通过自注意力机制显著提高了序列到序列模型的性能,为后续的大型语言模型奠定了基础。

2、BERT(2018年):由谷歌开发的BERT(Bidirectional Encoder Representations from Transformers)模型,通过在大型文本数据集上进行预训练,显著提高了NLP任务的性能。BERT的成功证明了大规模预训练模型的潜力。

3、GPT-1、GPT-2和GPT-3(2018-2020年):由OpenAI开发的GPT(Generative Pre-trained Transformer)系列模型,通过增加模型的大小和训练数据的规模,不断刷新NLP任务的基准。特别是GPT-3,其参数量达到1750亿,展现了巨大的能力。

4、其他大型语言模型:除了GPT系列外,其他如RoBERTa、T5、XLNet等模型也在各种NLP任务中取得了领先的结果。

主要特点和能力

规模庞大:动辄数亿到数万亿的参数量,使得模型能够学习和理解大量的上下文信息。

预训练-微调范式:大多数大模型都遵循这种范式,即在大量文本数据上进行预训练,然后在特定任务上进行微调。

泛化能力:大模型展现了强大的泛化能力,可以应用于广泛的NLP任务,包括但不限于文本分类、问答系统、文本生成、机器翻译等。

应用与影响

自然语言理解和生成:大模型在文本摘要、文本分类、情感分析、问答系统等方面表现出色。

对话系统:能够生成更加自然和流畅的回复,推动了聊天机器人和虚拟助手的进步。

创作和写作辅助:通过文本生成能力,大模型可以协助进行创作、撰写摘要等。

挑战和未来方向

计算资源和环境影响:训练大型模型需要巨大的计算资源和能源消耗,对环境的影响不可忽视。

偏见和伦理:大模型可能会从训练数据中学习到偏见,并可能被用于恶意目的,因此需要更严格的评估和伦理考虑。

解释性和可控性:由于模型的复杂性,其决策过程和输出结果的解释性仍然是一个挑战。

AI大模型的发展正在不断加速,未来我们可以期待在多模态学习(文本、图像、语音的统一处理)、提高模型的效率和可解释性等方面取得更多进展。

0

IP地址: 210.24.0.183

搜索次数: 1

提问时间: 2025-04-21 16:37:55

❓️ 热门提问:

ai语音模型

ai换脸照片合成

1千克黄金有多大

查找域名地址

0.09克黄金值多少钱

php集成开发环境

3克黄金手链多少钱一条

域名端口查询

ai 3d美女

ai学习应用

豌豆Ai站群搜索引擎系统

🤝 关于我们:

三乐Ai

作文批改

英语分析

在线翻译

拍照识图

Ai提问

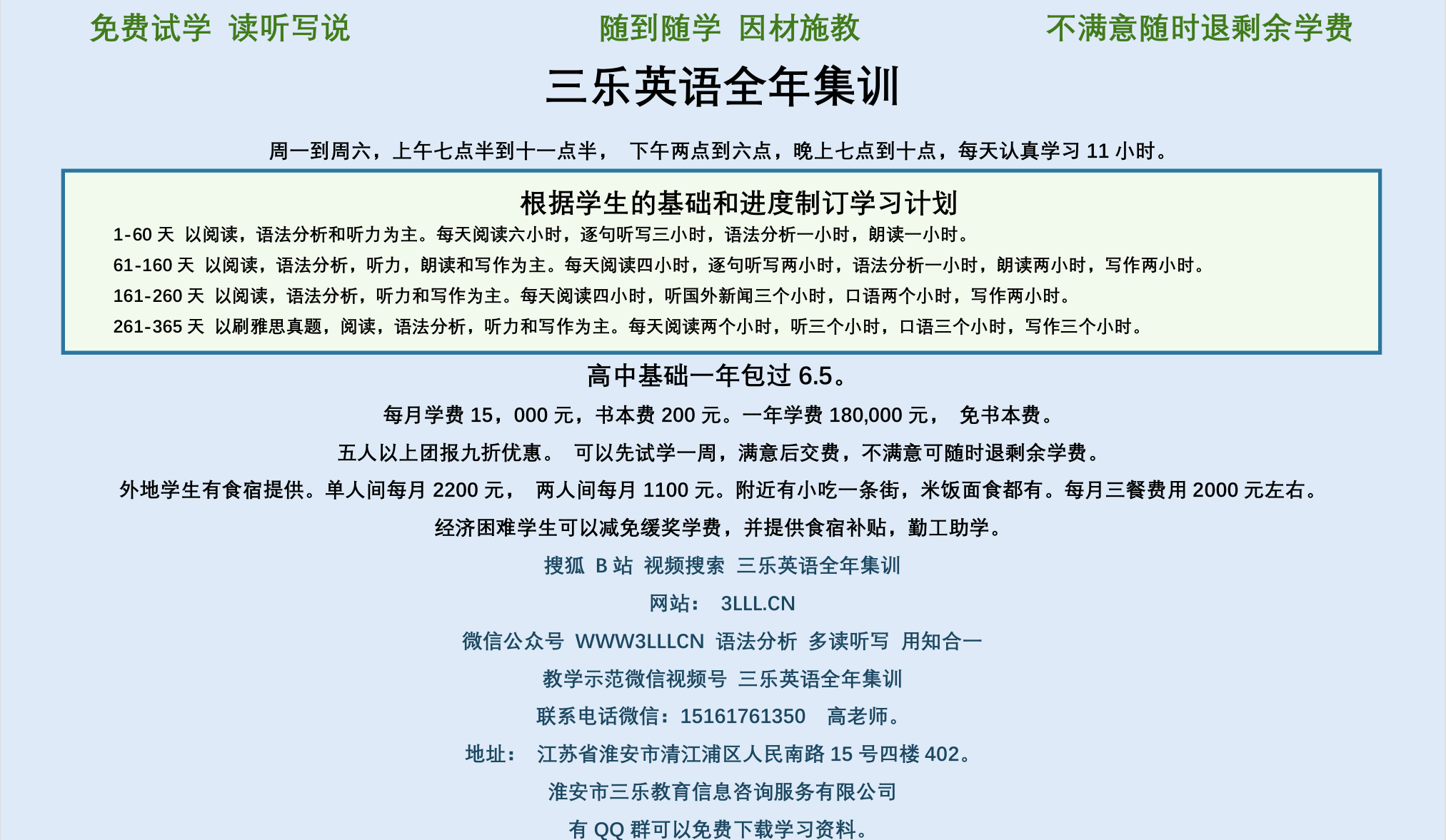

英语培训

本站流量

联系我们

📢 温馨提示:本站所有问答由Ai自动创作,内容仅供参考,若有误差请用“联系”里面信息通知我们人工修改或删除。

👉 技术支持:本站由豌豆Ai提供技术支持,使用的最新版:《豌豆Ai站群搜索引擎系统 V.25.05.20》搭建本站。